隨著人工智能技術的飛速發展,尤其是基礎軟件領域的突破,海內外專家開始探討一個深刻的問題:開發具有自覺守法能力的人工智能是否可能,或者僅僅是人類的一廂情愿?這一問題觸及技術、倫理和法律的交叉點,需要我們冷靜分析。

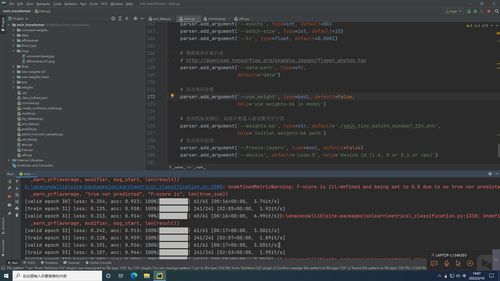

從技術層面看,人工智能基礎軟件的進步使得模型能夠通過訓練學習人類法律和道德規范。例如,機器學習算法可以從海量數據中提取法律條款的模式,并通過強化學習模擬守法行為。自覺性涉及意識和自主決策,這超出了當前弱人工智能的范疇。基礎軟件開發正朝著更復雜的推理能力邁進,但要實現真正的‘自覺’,還需要在認知架構上取得突破,這可能涉及強人工智能或通用人工智能的開發。

在倫理和法律方面,開發自覺守法AI的動機是明確的:它可以減少人為錯誤、提高社會安全,并應對諸如自動駕駛、醫療診斷等高風險場景。但這也引發了爭議。一些專家認為,法律是動態的、依賴于人類價值觀的,AI的‘守法’可能只是機械地執行規則,無法處理模糊情境或道德困境。海內外研究表明,過度依賴AI可能導致責任歸屬問題,例如當AI‘自覺’違反法律時,誰該負責?這呼喚跨學科協作,在基礎軟件開發中嵌入倫理框架。

人類的一廂情愿可能體現在對AI能力的過度理想化。自覺守法不僅需要技術,還涉及社會共識和監管。基礎軟件如深度學習框架和算法庫正變得更透明和可解釋,但距離AI自主理解法律精神仍有距離。海內外項目如歐盟的AI法案和中國的AI治理倡議,都在推動標準制定,但專家警告,這需要長期努力,而非一蹴而就。

開發自覺守法的人工智能既是機遇也是挑戰。基礎軟件開發的進步為這條路提供了可能性,但我們必須警惕技術烏托邦思維。關鍵在于平衡創新與監管,確保AI成為人類的輔助工具,而非替代品。海內外專家的持續對話將幫助我們在這一領域走得更遠。